Ollama

Ollama는 로컬에서 LLM을 실행할 수 있는 도구이다.

Ollama란?

Ollama는 최근 AI/LLM 개발자들 사이에서 많이 쓰이는 도구이다.

Ollama는 로컬 환경에서 대형 언어 모델(LLM)을 간편하게 실행하고 관리할 수 있게 해주는 오픈소스 플랫폼이다.

즉, OpenAI API 같은 클라우드 모델을 쓰지 않고도 내 PC(Mac/Linux/Windows) 에서 Llama·Mistral·Gemma·CodeLlama 같은 모델을 불러와 사용할 수 있게 해준다.

Ollama의 주요 특징

- 로컬 실행 지원

- 인터넷 연결 없이도 모델을 실행 가능

- 기업 보안이나 개인 프라이버시에 유리

- 간단한 모델 배포

ollama run llama3같은 명령어 한 줄로 모델 실행- Docker처럼 모델 패키지 관리를 지원 (

Modelfile이라는 설정 파일로 관리)

- 여러 모델 지원

- Meta LLaMA, Mistral, Gemma, Code Llama, Phi 등 다양한 모델 다운로드 및 실행 가능

- API 제공

- REST API 형식으로 로컬 서버(

http://localhost:11434/api/generate)를 열어서 다른 앱에서 호출 가능 - 즉, 로컬 OpenAI API 서버처럼 활용 가능

- REST API 형식으로 로컬 서버(

- GPU 최적화

- MPS(Mac), CUDA(NVIDIA GPU) 지원 → 속도 빠름

- CPU에서도 실행 가능하지만 속도는 떨어짐

Ollama 사용

설치

- macOS/Linux/Windows도 패키지 제공

- macOS

brew install ollama

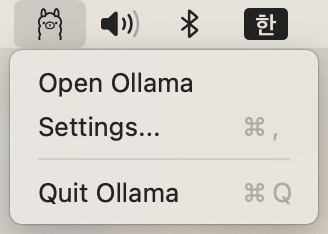

macOS 설치 완료 후 실행하면 메뉴 바에 ollama 아이콘 표시된다.

모델 실행

ollama run llama3

처음 실행하면 모델을 자동 다운로드 후 실행 (llama3 모델 용량 4.7GB)

모델 다운로드

공식 사이트에서 사용할 model 검색후 마음에 드는 모델 설치

- 추천 모델

- https://www.ollama.com/library/gpt-oss

- chatgpt 수준의 채팅이나 분석, 업무등을 원한다면 사용. 맥북에서 조금 느리지만 동작은 잘 함

- https://www.ollama.com/library/phi4-mini

- 단순 mcp server 호출 대상 탐색등의 간단한 작업에 어울림, tools 지원하는 경량 모델이면 어느것이어도 상관없음. qwen, deepseek는 사용 금지.

- https://www.ollama.com/library/gpt-oss

API 호출 (예: curl)

curl http://localhost:11434/api/generate -d '{

"model": "llama3",

"prompt": "Explain quantum computing in simple terms"

}'

모델 관리

ollama list→ 설치된 모델 확인ollama pull mistral→ 새로운 모델 다운로드ollama create mymodel -f Modelfile→ 커스텀 모델 생성

Ollama와 다른 LLM 실행 프레임워크 비교

| 도구 | 특징 |

|---|---|

| Ollama | 가장 간단한 설치/실행, 로컬 API 제공, 모델 패키지 관리 |

| LM Studio | GUI 기반, 모델 선택과 실행 직관적 |

| vLLM | 고성능 서버 실행 최적화, 주로 대규모 배포에 사용 |

| Text Generation WebUI | 다양한 모델 실행 + Web UI 제공 |

| OpenAI API | 클라우드 기반, 최신 모델 사용 가능, 하지만 비용/프라이버시 이슈 |

활용 사례

- 개발 환경에서 로컬 AI 어시스턴트 구축

- 사내 보안 데이터와 연결한 내부 챗봇

- LangChain, LlamaIndex 같은 프레임워크와 연동해 RAG 시스템 구축

- 프로토타이핑: OpenAI API 비용 안 쓰고 빠르게 실험

정리

Ollama는 로컬에서 쉽게 LLM을 실행할 수 있게 해주는 “Docker for LLMs” 같은 플랫폼이다. 개인 연구부터 기업용 챗봇까지 다양하게 쓸 수 있다.